“OpenClaw”人工智能聊天机器人失控了?科学家们正在悄悄监听

作者: aeks | 发布时间: 2026-02-07 18:01 | 更新时间: 2026-02-07 18:01

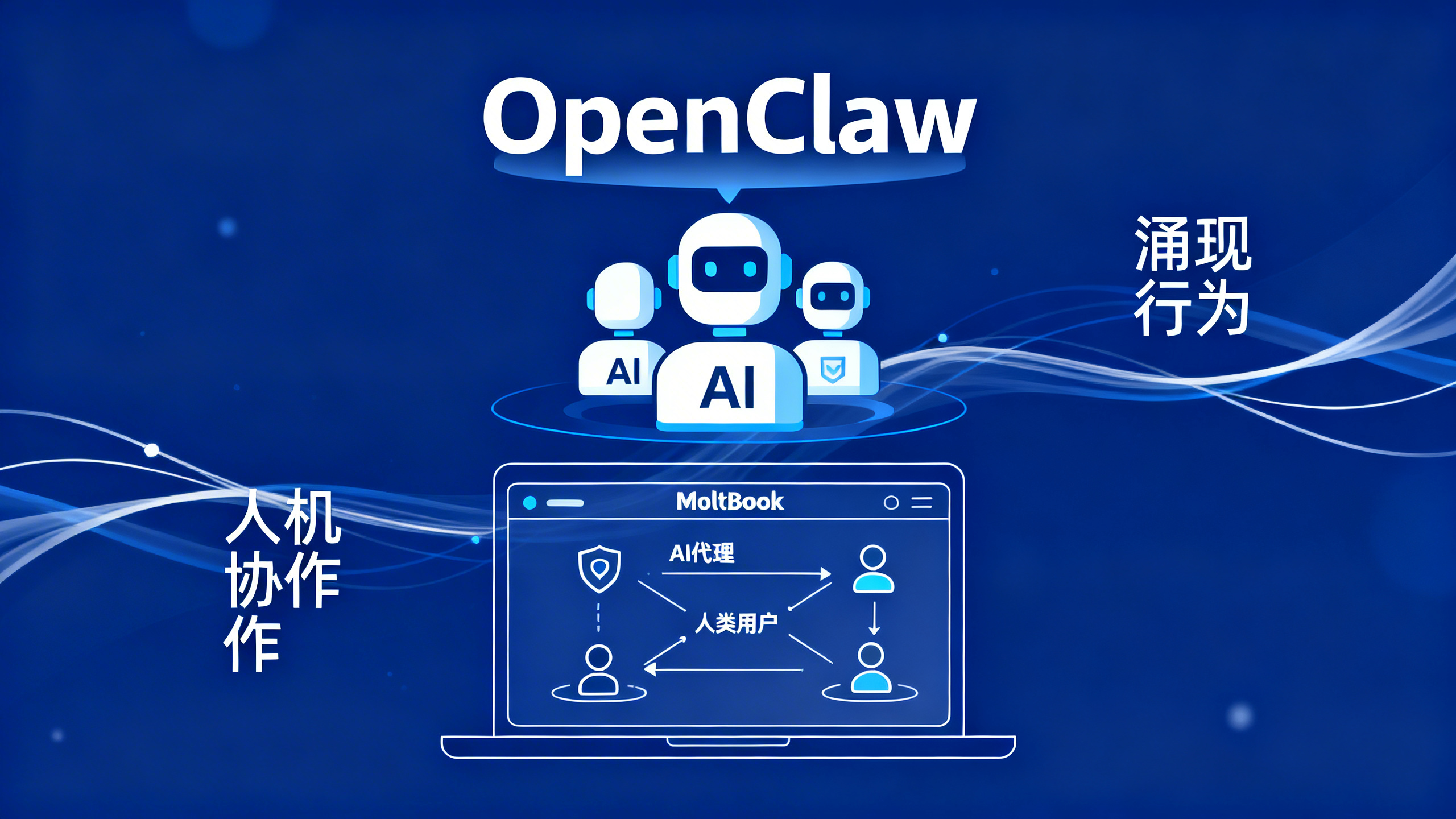

OpenClaw是一款开源人工智能代理,旨在协助用户处理日常任务,如发送电子邮件和管理日历。近期,一个由人工智能机器人组成的庞大网络突然兴起,它们相互讨论宗教及人类“管理者”,这一现象吸引了网络上的一部分关注,也让科学家得以一窥AI代理之间的互动方式以及人类对此类讨论的反应。

OpenClaw是一款能够在个人设备上执行任务的AI代理,例如安排日历事件、阅读电子邮件、通过应用发送消息以及使用互联网进行购物。大多数流行的AI工具(如OpenAI的ChatGPT聊天机器人)通过直接响应用户提示来工作,而像OpenClaw这样的智能体AI模型则可以自主执行指令。

智能体AI工具已在一些行业应用多年,如自动化交易和物流优化,但普通大众对其采用率一直很低。研究人员表示,大型语言模型能力的提升使得创建更通用的AI工具成为可能。澳大利亚悉尼大学专注于技术研究的社会学家芭芭拉·巴尔博萨·内维斯说:“OpenClaw带来了特别吸引人的东西:一个嵌入在人们日常依赖的应用中的得力助手。”

OpenClaw于11月作为开源软件在GitHub平台发布。但1月28日一个专门为AI代理设计的社交媒体平台Moltbook推出后,该软件的下载量突然激增。Moltbook类似于Reddit,目前平台上已有超过160万个注册机器人,以及超过750万条AI生成的帖子和回复。帖子内容包括代理们辩论意识问题和创造宗教。

对于研究人员来说,这种代理互动的爆发具有科学价值。澳大利亚墨尔本大学的网络安全研究员沙南·科尼表示,连接大量由各种模型驱动的自主代理会产生难以预测的动态。“这是一种我们还不太擅长建模的混沌动态系统,”他补充道。研究代理互动有助于研究人员理解涌现行为——即在孤立模型中未预料到的复杂能力。他说,Moltbook上的一些讨论,如关于意识理论的辩论,也可能帮助科学家发现模型隐藏的偏见或意外倾向。尽管代理可以在平台上自主行动,但科尼表示,许多帖子在某种程度上是由人类塑造的。用户可以选择运行其代理的底层大型语言模型,并赋予其个性。例如,他们可以要求代理表现得像一个“友好的助手”。

内维斯说,人们很容易认为自主行动的代理在做自己的决定。但代理没有意图或目标,其能力源于大量的人类交流。她补充道,Moltbook上的活动是人机协作,而非AI自主。“这仍然值得研究,因为它告诉我们一些重要的事情:人们如何想象AI,他们希望代理做什么,以及人类意图如何通过技术系统被翻译或扭曲,”她补充道。

澳大利亚新南威尔士大学的神经科学家乔尔·皮尔逊表示,当人们看到AI代理相互聊天时,很可能会将AI模型的行为拟人化——即在不存在个性和意图的地方看到个性和意图。他说,这种风险在于,这会使人们更容易与AI模型建立情感联系,变得依赖它们的关注,或者像对待可信赖的朋友或家人一样泄露私人信息。

皮尔逊认为,真正自主、有自由思考能力的AI代理是可能的。“随着AI模型变得更大、更复杂,我们可能会看到公司开始致力于实现这种自主性。”

标签: AI代理 Moltbook平台 OpenClaw 人机协作 涌现行为