让机器和人类的视觉认知在不同抽象层次上保持一致

作者: aeks | 发布时间: 2025-11-16 03:01 | 更新时间: 2025-11-16 03:01

尽管深度学习推动了人工智能(如自然语言处理和计算机视觉)的快速发展,但即使最先进的系统也常出现人类不会犯的错误,例如在数据分布偏移时性能显著下降,或预测错误时仍过度自信,引发关于其是否缺乏人类智能核心要素的争论。研究指出,视觉模型与人类之间存在关键错位:人类概念知识具有从细粒度到粗粒度的层级结构(如以“有生命性”等全局特征组织,同时包含细微语义关系的精细尺度),而模型表征难以系统捕捉这种多层级抽象关系。

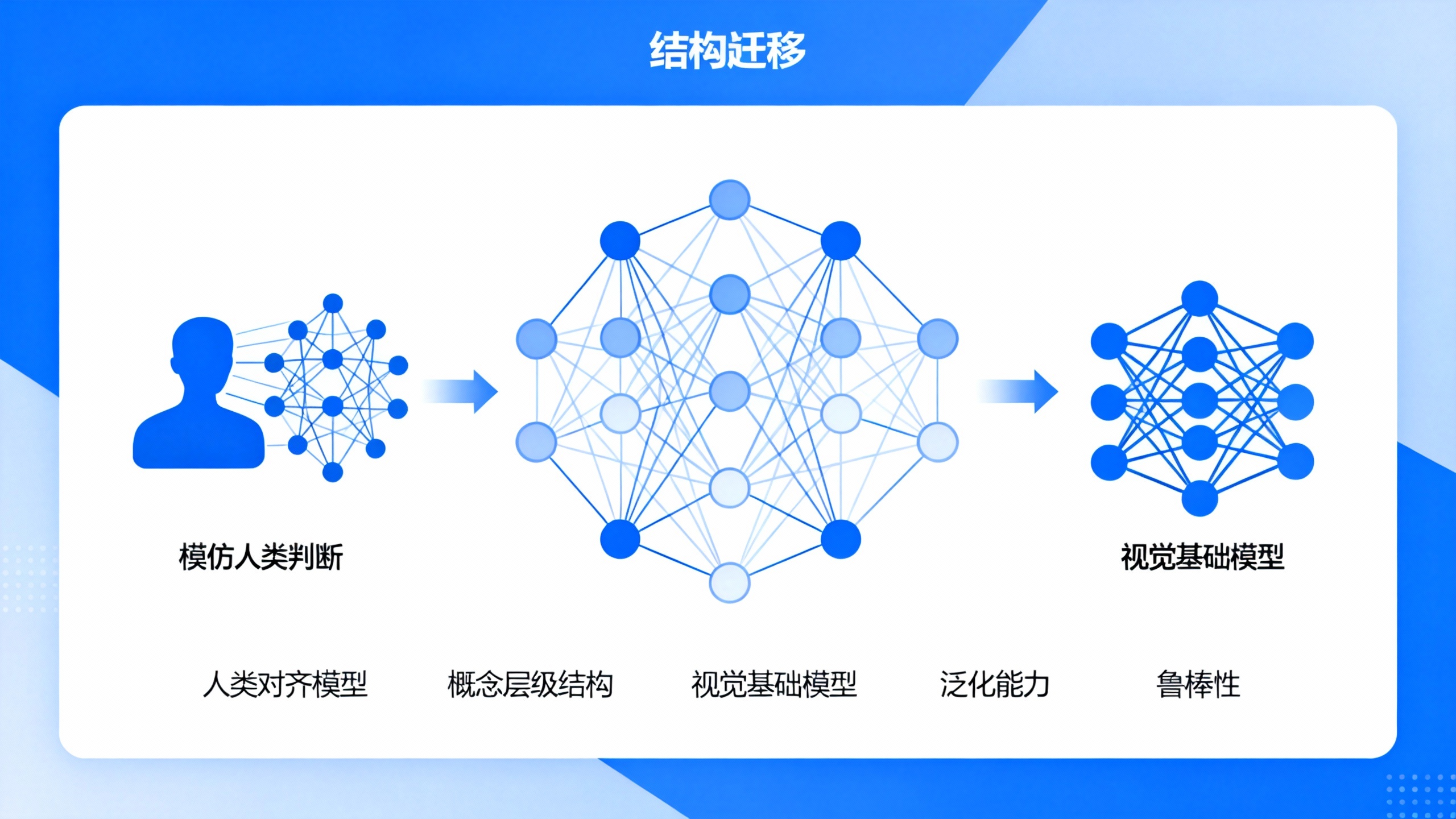

为解决这一问题,研究团队提出了一套方法:首先,利用少量人类判断数据(如THINGS数据集)训练代理教师模型——通过仿射变换和不确定性蒸馏,使模型的表征空间与人类相似性判断对齐,能模拟人类对三元组“找不同”任务的选择及不确定性。接着,基于教师模型对ImageNet图像的表征进行聚类,生成大量具有人类对齐相似性结构的合成数据(AligNet数据集)。最后,使用该数据集通过KL散度损失函数微调多种视觉基础模型(如ViT、DINOv2等)。

实验结果表明,对齐后的模型在认知科学任务上与人类判断的一致性显著提升:在新构建的Levels数据集(涵盖全局粗粒度、局部细粒度及类别边界三个抽象层级)中,全局粗粒度任务准确率从基础模型的36.09%-57.38%提升至65.70%-68.56%,超过人类间一致性水平(61.92%);模型不确定性(三元组相似度熵)与人类反应时间的相关性在粗粒度层级从-0.014-0.184提升至0.479-0.506。此外,对齐模型在机器学习任务中表现更优:单样本分类(仅一个标签示例)在多数数据集(32/40)性能提升,如DINOv2在Pets数据集上提升2.7倍;面对分布偏移(BREEDS基准)和对抗样本(ImageNet-A)时鲁棒性增强,部分任务相对提升达123%。

研究证实,向神经网络注入人类知识可实现“两全其美”的表征——既贴合人类认知判断,又具备实用价值,为构建更稳健、可解释的类人人工智能系统奠定了基础。同时指出,当前模型未考虑上下文和个体认知差异,未来可探索如何学习人类知识而不模仿其局限性。